A medida que la inteligencia artificial (IA) comienza a dejar su huella en la atención sanitaria, las preguntas sobre el uso ético y responsable de la misma han pasado al foco de debate. ¿Hasta qué punto podemos confiar en algoritmos de inteligencia artificial cuando se trata de asuntos de vida o muerte o de salud personal y bienestar? ¿Cómo garantizamos que estos algoritmos se utilicen para los propósitos previstos? ¿Y cómo nos aseguramos de que la inteligencia artificial no discrimine inadvertidamente culturas, minorías u otros grupos específicos, perpetuando así las desigualdades en el acceso y la calidad de la atención? Estas preguntas son demasiado importantes para ser respondidas después. Nos obligan a pensar de forma proactiva: como industria y como individuos, cómo podemos mejorar la IA en la atención médica y la vida saludable para beneficio de los consumidores, los pacientes y los profesionales de la atención y evitar al mismo tiempo consecuencias no deseadas.

¿Cómo podemos mejorar en la IA en la atención médica y la vida saludable en beneficio de las personas, y evitar al mismo tiempo consecuencias no deseadas?

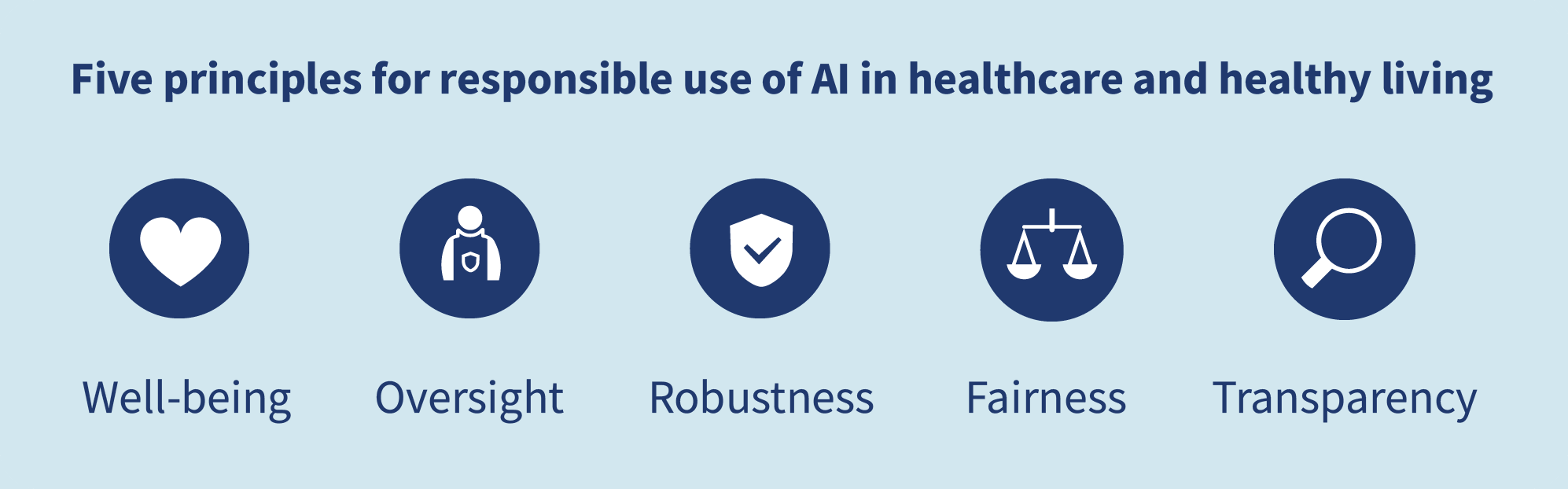

Como el uso de la IA en aplicaciones de atención médica y salud personal a menudo implica el uso de datos personales confidenciales, una prioridad clave es utilizar esos datos de manera responsable. Los datos deben mantenerse seguros y protegidos en todo momento, y procesarse en conformidad con todas las regulaciones de privacidad pertinentes. En Philips, lo reflejamos en nuestros Principios de datos. Sin embargo, debido a que la IA está lista para cambiar de forma fundamental la forma en que las personas interactúan con la tecnología y toman decisiones, requiere estándares y seguridad adicionales. Las Directrices de datos no son suficientes por si solas. Esto nos llevó a desarrollar un conjunto de cinco principios necesarios para el diseño y el uso responsable de la IA en aplicaciones de atención médica y salud personal, todo basado en la noción clave de que las soluciones habilitadas para la IA deben complementar y beneficiar a los clientes, pacientes y a la sociedad en su conjunto.

¿Qué implican cada uno de estos principios y por qué son tan importantes?

1. Bienestar

Las soluciones habilitadas para la IA deben beneficiar la salud y el bienestar de las personas y contribuir al desarrollo sostenible de la sociedad. Al igual que con cualquier innovación tecnológica, ante todo debemos preguntarnos a qué propósito humano debe servir la IA. El objetivo no debe ser mejorar la IA por su bien, sino mejorar el bienestar y la calidad de vida de las personas. Con la creciente demanda mundial de atención médica y la creciente escasez de profesionales de la salud, existe una clara necesidad de la IA para ayudar a aliviar los sistemas de salud sobrecargados. Ya se escribió sobre cómo la IA puede actuar como un asistente inteligente de los proveedores de atención médica en el diagnóstico y el tratamiento, todo ello con el potencial de mejorar los resultados de salud a un menor costo, al tiempo que mejora la experiencia del personal y del paciente (conocido como el Objetivo cuádruple). Pero para beneficiar en realidad la salud y el bienestar de las personas durante las generaciones venideras, tenemos que pensar más allá del modelo actual reactivo de “atención por enfermedad”. Con la IA, podemos avanzar hacia una atención médica verdadera y proactiva. En cada paso de la vida de las personas, desde la cuna hasta la vejez, las aplicaciones y los servicios de salud impulsados por la IA podrían informar y apoyar la vida saludable con orientación y consejos personalizados, la prevención y el tratamiento de enfermedades.

Con la IA, podemos pasar de la atención reactiva por enfermedad a la atención médica proactiva.

Este no debe ser el privilegio de unos pocos. En acuerdo con los Objetivos de desarrollo sostenible de las Naciones Unidas, creo que debemos adoptar un enfoque inclusivo que promueva el acceso a la atención y a una vida saludable para todos. En la actualidad, en muchos países en desarrollo, existen grandes desigualdades entre los servicios de salud urbanos y rurales. La IA, combinada con otras tecnologías habilitantes como el Internet de las cosas y tecnologías de telecomunicaciones de alto ancho de banda como el 5G, podría ayudar a reducir estas desigualdades al hacer que el conocimiento médico especializado esté disponible en las zonas rurales [1].

2. Supervisión

Las soluciones habilitadas para la IA deben aumentar y empoderar a las personas, con una supervisión adecuada. Ahora que hemos establecido el bienestar humano como el propósito rector para el desarrollo de la IA, ¿cómo nos aseguramos de que la IA cumpla ese objetivo? Como he argumentado antes, la IA aumenta las habilidades humanas y la experiencia, pero no las hace menos relevantes. Especialmente en el complejo mundo de la atención médica, donde las vidas están en juego, las herramientas de IA como el aprendizaje automático requieren conocimiento y experiencia en el dominio humano para poner sus resultados en contexto. Un ejemplo clásico de la literatura médica puede ayudar a ilustrar esto, al mostrar lo que podría salir mal si tuviéramos que confiar ciegamente en algoritmos. A mediados de los años 90, un equipo de investigación multiinstitucional creó un modelo de aprendizaje automático para predecir la probabilidad de muerte de pacientes con neumonía. El objetivo era garantizar que los pacientes de alto riesgo fueran ingresados en el hospital, mientras que los pacientes de bajo riesgo podían ser tratados como pacientes ambulatorios. Con base en los datos de formación, el modelo infirió que los pacientes con neumonía que tienen antecedentes de asma tienen menor riesgo de morir de neumonía que la población general, un hallazgo que se burla del conocimiento médico común [2]. Sin una comprensión más profunda de los datos, esto podría haber llevado a la conclusión errónea de que los pacientes con neumonía con antecedentes de asma no necesitaban atención hospitalaria con la misma urgencia. Pero esto no podría haber estado más lejos de la verdad. Lo que realmente explicó el patrón en los datos es que los pacientes con antecedentes de asma generalmente fueron ingresados directamente en la Unidad de Cuidados Intensivos cuando se presentaron en el hospital con neumonía. Esto redujo su riesgo de morir de neumonía, en comparación con la población general. Si no hubieran recibido esa atención proactiva, de hecho habrían tenido un riesgo mucho mayor de morir. No había nada de malo en el modelo de aprendizaje automático per se, pero la correlación que había identificado sobre la base del conjunto de datos de entrenamiento era peligrosamente engañosa. Este ejemplo muestra lo crucial que es que el poder de análisis de datos de la IA vaya de la mano con el conocimiento del dominio de los expertos humanos y la ciencia clínica establecida. Uno no puede ir sin el otro.

El poder de análisis de datos de la IA debe ir de la mano con el conocimiento del dominio de los expertos humanos y la ciencia clínica establecida.

En la investigación médica, por lo tanto, es esencial reunir a ingenieros de IA, científicos de datos y expertos clínicos. Esto ayuda a garantizar una validación e interpretación adecuadas de las perspectivas generadas por la IA. Una vez que una aplicación de IA ha llegado a la práctica clínica, puede ser una poderosa herramienta de apoyo a la toma de decisiones, pero todavía requiere supervisión humana. El médico debe juzgar y revisar sus hallazgos y recomendaciones, con base en una comprensión holística del contexto del paciente.

3. Solidez

Las soluciones habilitadas para la IA no deben hacer daño y deben tener una protección adecuada contra el uso indebido deliberado o involuntario. Para promover la aplicación responsable de la IA, también necesitamos establecer las protecciones necesarias para evitar el uso indebido involuntario o deliberado. Tener un conjunto sólido de mecanismos de control ayudará a inculcar confianza mientras mitiga los riesgos potenciales. Esto es particularmente importante porque el mal uso puede ser sutil y podría ocurrir inadvertidamente, con la mejor de las intenciones. Por ejemplo, supongamos que se desarrolla un algoritmo para ayudar a detectar cáncer de pulmón mediante tomografías computarizadas en dosis bajas. Una vez que el algoritmo ha demostrado ser eficaz para esta aplicación, con una alta sensibilidad para detectar posibles signos de cáncer de pulmón, puede parecer obvio extender su uso también a un entorno de diagnóstico. Pero para un uso eficaz y confiable en ese entorno, es posible que el algoritmo se sintonice de manera diferente, para aumentar la especificidad y descartar a las personas que realmente no tienen cáncer de pulmón. Un algoritmo totalmente diferente podría incluso funcionar mejor. Diferentes configuraciones, diferentes demandas. Una forma de prevenir el mal uso (involuntario) es monitorear el rendimiento de las soluciones habilitadas para la IA en la práctica clínica, y comparar los resultados reales con los obtenidos en la capacitación y validación. Cualquier discrepancia significativa requeriría una mayor inspección. La formación y la educación también pueden ayudar mucho a salvaguardar el uso adecuado de la IA. Es vital que cada usuario tenga una comprensión profunda de las fortalezas y limitaciones de una solución específica habilitada para IA.

4. Imparcialidad

Creemos que las soluciones habilitadas para IA se deben desarrollar y validar con datos representativos del grupo objetivo para el uso previsto, y evitar al mismo tiempo sesgos y discriminación. Otra prioridad es asegurarse de que la IA sea imparcial y libre de sesgos. Debemos ser conscientes de que la IA es tan objetiva como los datos que alimentamos en ella. El sesgo podría introducirse fácilmente si un algoritmo se desarrollara y entrenara sobre la base de un subconjunto específico de la población, y luego se aplicara a una población más amplia. Por ejemplo, la disección espontánea de arterias coronarias (SCAD, por sus siglas en inglés): una afección rara y a menudo mortal que causa un desgarro en un vaso sanguíneo del corazón. El 80 % de los casos de SCAD involucran a mujeres, pero las mujeres suelen estar subrepresentadas en ensayos clínicos que investigan SCAD [3]. Si desarrollamos una herramienta de apoyo a la decisión clínica basada en la IA y en datos de esos ensayos clínicos, aprendería de datos predominantemente masculinos. Como resultado, la herramienta puede no capturar completamente los entresijos de la enfermedad en las mujeres, perpetuando el sesgo que ya estaba presente en los ensayos. Riesgos similares surgen cuando se desarrolla un algoritmo de IA en una región del mundo y luego se aplica en otra región sin revalidarlo primero en los datos locales. Por ejemplo, las condiciones cardiovasculares suelen afectar a las personas de la India 10 años antes que a las personas de ascendencia europea [4]. Por lo tanto, si un algoritmo se ha entrenado solo en personas europeas, puede que no recoja los primeros signos de la enfermedad cardiovascular en los indios. ¿Cómo prevenir este tipo de sesgos? En primer lugar, el desarrollo y la validación de la IA deben basarse en datos que representen con precisión la diversidad de personas en el grupo objetivo. Cuando la IA se aplica a un grupo de destino diferente, primero se debe revalidar y, posiblemente, volver a entrenarse.

El desarrollo y la validación de la IA deben basarse en datos que representen con precisión la diversidad de personas en el grupo objetivo.

A partir de mi experiencia en Philips, tener una organización diversa, con equipos de investigación en China, los Estados Unidos, la India y Europa, también ayuda a crear conciencia sobre la importancia de la imparcialidad en la IA. La diversidad en los orígenes fomenta una mentalidad inclusiva.

5. Transparencia

Las soluciones habilitadas para IA requieren divulgación sobre qué funciones y características están habilitadas para el uso de la misma, el proceso de validación y la responsabilidad de la toma de decisiones definitiva. Como quinto y último principio, la confianza pública y la adopción más amplia de la IA en la atención médica dependerán en última instancia de la transparencia. Cada vez que se aplica la IA en una solución, tenemos que ser abiertos sobre esto y revelar cómo se validó, qué conjuntos de datos se utilizaron y cuáles fueron los resultados pertinentes. También debe quedar claro cuál es el papel del profesional sanitario en la toma de una decisión final. Pero quizás lo más importante es que se puede lograr una transparencia óptima mediante el desarrollo de soluciones habilitadas para la IA en asociación. Al forjar una estrecha colaboración entre diferentes actores del sistema de salud, proveedores, pagadores, pacientes, investigadores, reguladores, podemos descubrir y abordar conjuntamente las diversas necesidades, demandas e inquietudes que deben tenerse en cuenta al desarrollar soluciones habilitadas para la IA. No como una idea tardía, sino desde el principio, en un diálogo abierto e informado.

Configurar juntos el futuro de la IA en la atención médica

En conjunto, creo que estos cinco principios pueden ayudar a allanar el camino hacia el uso responsable de la IA en aplicaciones sanitarias y de salud personal. Sin embargo, también me doy cuenta de que ninguno de nosotros tiene todas las respuestas. Surgirán nuevas preguntas a medida que continuemos en este emocionante camino de descubrimiento e innovación con la IA, y espero con interés discutirlas juntos. Leer más sobre los Principios de IA de Philips Referencias [1] Guo J, Li B. La aplicación de la tecnología de inteligencia artificial médica en las zonas rurales de los países en desarrollo. Health Equity. 2018;2(1):174–181. [2] Cooper G, Aliferis C, Ambrosino R, et al. Una evaluación de los métodos de aprendizaje automático para predecir la mortalidad por neumonía. Artificial Intelligence in Medicine. 1997;9(2):107–138. [3] Perdoncina E, Duvernoy C. Tratamiento de la Enfermedad arterial coronaria en mujeres. Cardiovasc J. 2017;13(4):201–208. [4] Prabhakaran D, Jeemon P, Roy A. Enfermedades Cardiovasculares en la India: Epidemiología actual y direcciones futuras. Circulation. 2016;133(16):1605-20.

Comparta en sus redes sociales

Temas

Autor

Henk van Houten

Former Chief Technology Officer at Royal Philips from 2016 to 2022